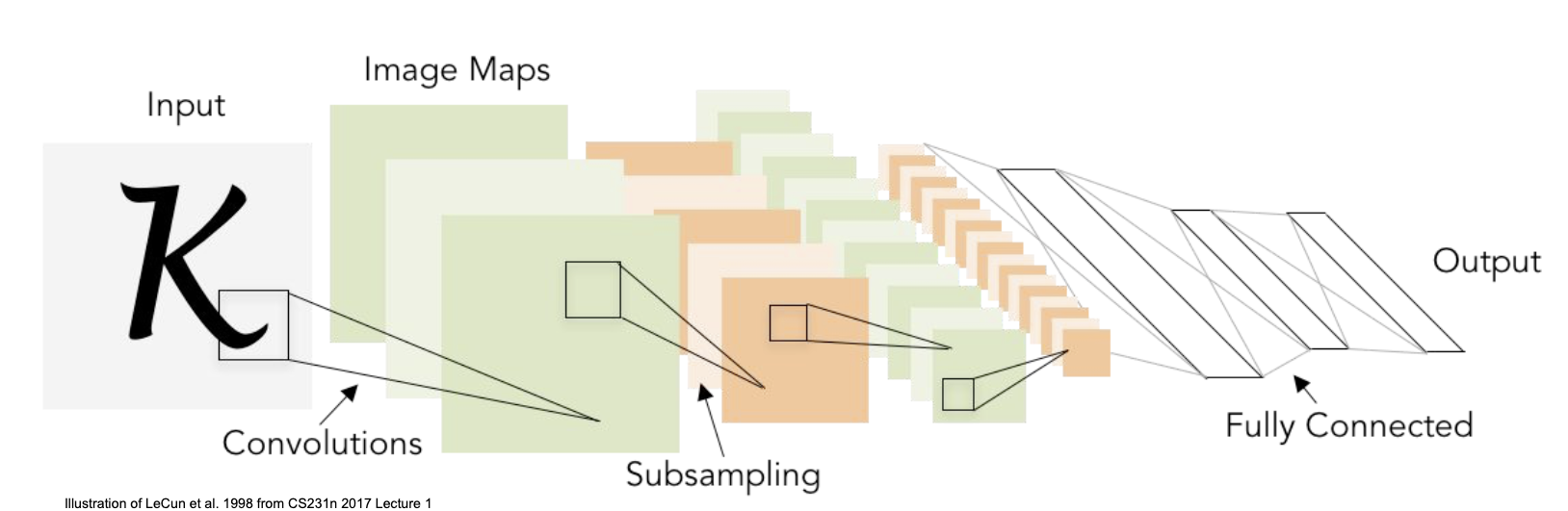

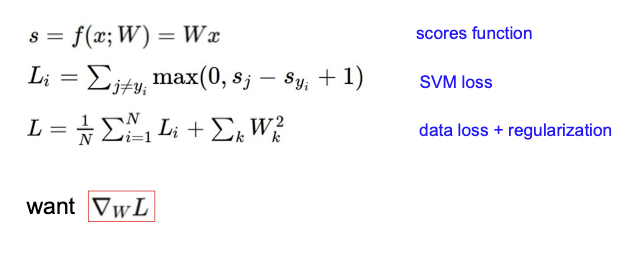

파이토치 한국커뮤니티가 워낙에 잘 되어있어서 튜토리얼 중 중요한 것들은 모두 번역이 되어 있다 🥹 부지런한 한국 사람들 최고... 아래 내용은 파이토치 한국 튜토리얼에 있는 내용을 따라하며 정리한 내용들이며, 추가적으로 부가 설명이 필요한 경우 (for me..!) 추가 서술이 되어있다. 1. Pytorch Tensor 파이토치에서 텐서는 기본적인 데이터 형태이다. 2017년 cs231n에는 텐서 외에도 다른 데이터 유형이 있었는데, 이를 모두 텐서로 병합했다. 가장 기본적인 자료 형태이니만큼 텐서의 종류엔 무엇이 있는 지, 무엇을 할 수 있을 지 알아보면 좋지만 이는 나중에 다른 글로 정리할 예정이다. 이번 정리에서는 간단하게 텐서 다루는 방법만 나온다. 텐서 생성 및 유형 확인 import torch..